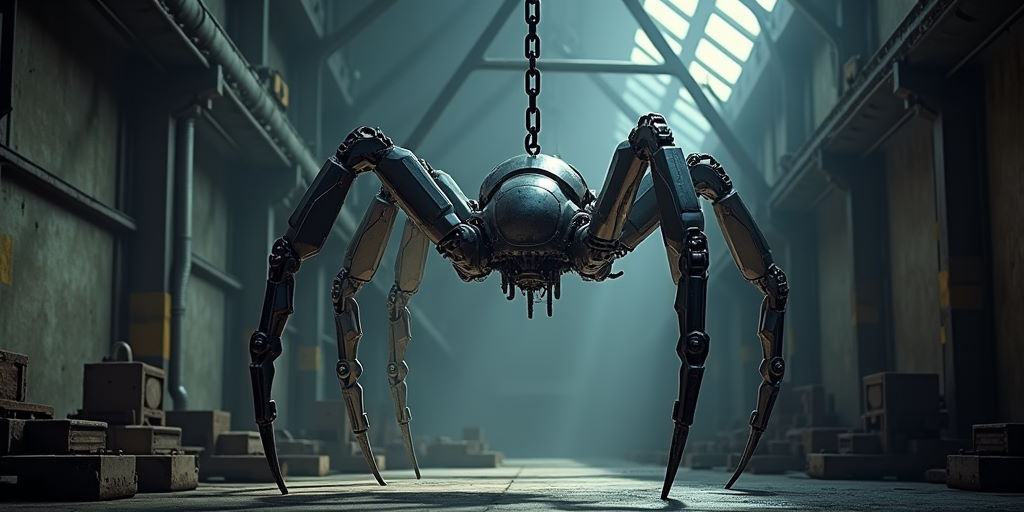

Programa automatizado que navega por la web de forma sistemática para recolectar información de sitios web

Un rastreador web, también conocido como crawler o spider, es un programa automatizado que navega por la web de forma sistemática para recolectar información de sitios web. Estos rastreadores son esenciales para el funcionamiento de los motores de búsqueda, como Google, Bing o Yahoo, ya que permiten indexar páginas web y almacenarlas en enormes bases de datos. Así, cuando un usuario realiza una búsqueda, el motor de búsqueda puede devolver los resultados más relevantes basados en la información previamente rastreada e indexada por estos programas.

Los rastreadores web siguen un proceso específico que incluye visitar páginas web, descargar su contenido (textos, imágenes, enlaces, etc.), y luego seguir los enlaces que encuentran en dichas páginas para continuar el proceso de rastreo en otras URL. Este ciclo permite que los motores de búsqueda mantengan un índice actualizado de sitios web disponibles en la red. El uso de rastreadores también es común en otras áreas, como la recopilación de datos para análisis de mercado, monitoreo de precios en el comercio electrónico o la búsqueda de vulnerabilidades en ciberseguridad.

Una característica clave del rastreador web es su capacidad para realizar este trabajo de manera automatizada y masiva, visitando millones de páginas en cortos periodos de tiempo. Los sitios web pueden influir en el comportamiento de estos rastreadores mediante la implementación de archivos robots.txt, que permiten indicar qué partes de un sitio deben o no ser rastreadas, controlando así qué información será accesible para los motores de búsqueda.

Ejemplos prácticos

El caso más emblemático del uso de rastreadores web lo encontramos en Google, cuyo famoso rastreador, llamado Googlebot, es responsable de indexar prácticamente todo el contenido disponible en la web pública. Googlebot sigue los enlaces de un sitio web a otro, construyendo un gigantesco índice que posteriormente se utiliza para ofrecer los resultados más relevantes a los usuarios en fracciones de segundo. Gracias a su sistema avanzado de rastreo, Google ha logrado ser el motor de búsqueda líder, proporcionando resultados actualizados y relevantes. El rastreador de Google está constantemente mejorando su capacidad para interpretar páginas con tecnologías modernas, como AJAX o JavaScript, lo que asegura que incluso los sitios más dinámicos puedan ser indexados correctamente.

Otro ejemplo interesante es el uso de rastreadores web en Amazon, que monitorea continuamente los precios de productos en otras tiendas online. A través de un rastreo automatizado, Amazon puede ajustar los precios de sus productos en tiempo real para mantenerse competitivo frente a otros sitios web de comercio electrónico. Esta práctica le permite ofrecer precios dinámicos que atraen a los consumidores y garantizan que siempre esté al tanto de los cambios en el mercado. Además, el rastreo de contenido de productos en otras webs les permite actualizar su catálogo y detectar rápidamente nuevas tendencias o lanzamientos de productos.

Un ejemplo de un uso inadecuado de rastreadores web lo encontramos en el caso de Mumsnet, un popular foro británico, que en 2017 fue víctima de un rastreador malicioso que accedió de forma agresiva a sus páginas y provocó una sobrecarga en sus servidores. Este tipo de rastreadores, que no respetan las reglas establecidas en archivos robots.txt, pueden causar problemas graves de rendimiento en sitios web y aumentar los costes de infraestructura. El caso de Mumsnet es un recordatorio de la importancia de gestionar adecuadamente el tráfico de rastreadores y asegurarse de que solo los rastreadores autorizados accedan al contenido del sitio.

Ideas y recursos útiles

Para las empresas que desean optimizar su visibilidad online o mejorar la eficiencia de sus procesos, el uso y control de rastreadores web puede ser un factor clave. Aquí presentamos algunas ideas y recursos útiles para sacar el máximo partido a los rastreadores y proteger tu sitio de posibles abusos:

- Optimización de sitios para motores de búsqueda: Uno de los principales usos de los rastreadores web es la indexación de sitios para los motores de búsqueda. Para asegurarte de que tu sitio sea fácilmente rastreable y, por lo tanto, mejor indexado, es importante optimizar su arquitectura y contenido. Un archivo robots.txt bien configurado puede indicarle a los rastreadores qué secciones de tu sitio deben evitar o priorizar. Además, herramientas como Google Search Console permiten verificar cómo Googlebot está rastreando tu sitio y solucionar problemas de indexación, como errores 404 o páginas duplicadas.

- Monitoreo de la competencia: Los rastreadores web no solo son útiles para motores de búsqueda, también pueden ser una herramienta valiosa para las empresas que desean monitorear a su competencia. Herramientas como Octoparse o Scrapy permiten a las empresas rastrear los sitios web de sus competidores y recopilar información clave sobre productos, precios, estrategias de marketing y contenido. De esta manera, puedes mantenerte al día con los movimientos del mercado y ajustar tus estrategias en función de los datos recopilados, lo que te da una ventaja competitiva en tiempo real.

- Análisis de contenido y SEO: Si estás gestionando un sitio web con mucho contenido, es fundamental asegurarse de que todo esté bien estructurado y optimizado para SEO. Herramientas como Screaming Frog actúan como un rastreador web que te permite analizar tu propio sitio, detectando problemas como enlaces rotos, duplicados de contenido o imágenes sin etiquetas alt. Estas herramientas también te ayudan a evaluar la estructura de enlaces internos, lo que es crucial para mejorar la navegación y la indexación de tu web. Al realizar auditorías periódicas con un rastreador, puedes identificar áreas de mejora y garantizar que tu sitio esté optimizado para atraer más tráfico orgánico.

- Protección contra rastreadores maliciosos: Aunque los rastreadores web tienen muchas aplicaciones legítimas, algunos pueden ser utilizados para fines maliciosos, como el scraping de contenido o la recolección de información sin permiso. Para proteger tu sitio web de este tipo de amenazas, es importante implementar herramientas de seguridad como Cloudflare o Sucuri, que ofrecen protección contra bots maliciosos y rastreadores no autorizados. Además, puedes utilizar el archivo robots.txt para limitar el acceso a determinadas secciones de tu sitio, aunque esto no garantiza una protección total contra rastreadores que ignoren estas directrices.

- Uso de APIs y servicios web para datos estructurados: En lugar de utilizar rastreadores web, que pueden sobrecargar los servidores o infringir términos de uso de sitios web, algunas empresas prefieren utilizar APIs para obtener datos de manera más eficiente y respetuosa. Muchas plataformas ofrecen APIs públicas que permiten a los desarrolladores acceder a información específica de forma estructurada, como productos, precios o datos de usuario. El uso de APIs reduce la carga en el servidor y garantiza que los datos obtenidos sean siempre precisos y actualizados. Algunos ejemplos incluyen la API de Twitter para extraer información de redes sociales o la API de Amazon para datos de productos.

- Controlar la frecuencia de rastreo: Para evitar sobrecargar los servidores, es importante controlar la frecuencia con la que los rastreadores acceden a tu sitio. En el caso de Google, a través de Google Search Console, puedes ajustar la frecuencia de rastreo para asegurarte de que Googlebot no cause problemas de rendimiento en tu web. Si tienes un sitio con muchos recursos o con contenido dinámico que se actualiza constantemente, puede ser útil reducir la frecuencia de rastreo para evitar picos de tráfico no deseado que puedan ralentizar tu sitio.

- Automatización de tareas con rastreadores: Más allá del SEO, los rastreadores web se utilizan para automatizar una amplia gama de tareas en diversas industrias. Por ejemplo, en el sector de la reputación online, los rastreadores pueden monitorizar menciones de marcas, productos o personas en foros, redes sociales y blogs. Empresas como Brandwatch utilizan esta tecnología para ofrecer servicios de análisis de sentimiento y monitoreo de menciones en la web. De esta forma, las marcas pueden reaccionar rápidamente ante comentarios negativos o aprovechar oportunidades de interacción con los consumidores en tiempo real.

- Cumplimiento de normativas y privacidad: Con la creciente preocupación por la privacidad de los datos y la implementación de normativas como el Reglamento General de Protección de Datos (GDPR) en la Unión Europea, es esencial que las empresas se aseguren de que sus rastreadores cumplan con las normativas locales. Cuando utilices rastreadores para recopilar datos de otros sitios web, es fundamental asegurarte de que no estás infringiendo ninguna política de privacidad o propiedad intelectual. Muchos sitios prohíben el scraping automatizado sin permiso, por lo que es crucial respetar los términos de uso de las webs que estás rastreando y obtener consentimiento adecuado si es necesario.

Los rastreadores web son una herramienta poderosa y versátil, fundamental para el funcionamiento de los motores de búsqueda y para muchas otras aplicaciones empresariales. Con su uso adecuado y responsable, las empresas pueden mejorar su visibilidad, monitorear el mercado y proteger sus activos digitales.

Otras secciones del

Diccionario de Marketing Digital

A | B | C | D | E | F | G | H | I | J | K | L | M | N | O | P | Q | R | S | T | U | V | W | Y | Z

Volver al inicio del

Diccionario de Marketing Digital

¿Conoces alguna palabra o expresión del marketing digital que no esté en este Diccionario? Añádela aquí.